De la energía atómica al microchip

Compartir

Datos principales

Rango

Mundo fin XX

Desarrollo

La "física de las partículas elementales" comenzaba su andadura de la mano de la mecánica cuántica, teoría fundamental de la estructura de la materia. Para ello fue preciso el desarrollo de la "física de altas energías", debido a la necesidad de romper las fuerzas de ligadura del núcleo atómico. En su primera etapa, el análisis de la estructura atómica se había realizado sobre la base de la radiación alfa (a). Para avanzar en el conocimiento de la estructura del núcleo atómico era necesario conseguir partículas a más energéticas; en 1932, John Cockcroft y Ernest Walton lograron, mediante un multiplicador voltaico, la desintegración artificial de átomos de litio en dos partículas a. Dando un paso más en esta dirección, Van de Fraaff diseñó un generador electrostático para acelerar partículas que alcanzaba los 80 kV, y ya en 1935 llegaba a los cinco millones de voltios (5 MV).El salto más significativo se produjo de la mano de Ernest Orlando Lawrence que, sobre la base de los trabajos de Rolf Wideröe, desarrolló el ciclotrón. Se fundamentaba en una estructura circular en la que las partículas cargadas entraban en un campo eléctrico alterno, logrando su aceleración por la diferencia de potencial. Lawrence aplicó al modelo de Wideröe la acción de campos magnéticos, que lograban un incremento sustancial de la aceleración de las partículas. En 1932, Lawrence lograba poner en funcionamiento el primer ciclotrón con la colaboración de M.

Stanley Livingston en Berkeley. Paralelamente, en la Universidad de Columbia (Nueva York), Harold Urey y su equipo descubrían un isótopo del hidrógeno: el deuterio, cuyo poder desintegrador era diez veces más potente que los protones. En 1936, con un ciclotrón más potente, se logró medir el momento magnético del neutrón, produciéndose además el primer elemento artificial: el tecnecio. El ciclotrón posibilitó la creación de isótopos radiactivos que pronto revelaron importantes aplicaciones, entre otras, en el campo de la medicina para el diagnóstico y tratamiento del cáncer.En 1938, Otto Hahn junto con su colaborador Fritz Strassmann observó con sorpresa la producción de bario como consecuencia del bombardeo del uranio con neutrones. Se encontraban frente a la primera reacción de fisión nuclear conocida. El 6 de enero de 1939 publicaban sorprendidos estos resultados. Lisa Meitner, antigua colaboradora de Hahn y exiliada en Estocolmo por su origen judío, fue la primera en interpretar correctamente el alcance del descubrimiento de Hahn junto con su sobrino Otto R. Frisch. La aplicación de la fórmula einsteiniana E = mc2 a la fisión del uranio revelaba dicho proceso como una fuente inagotable de energía. Las bases de la bomba atómica estaban puestas. La proximidad de la Segunda Guerra Mundial aceleró el proceso.Frisch comunicó los cálculos a Niels Bohr en Copenhague antes de que partiera a Estados Unidos. El 16 de enero de 1939, Bohr y su colaborador Leon Rosenfeld se encontraron en Nueva York con John Wheeler y Enrico Fermi, a los que comunicaron el hallazgo de Hahn y los resultados de Meitner y Frisch.

Inmediatamente los físicos en Norteamérica comenzaron a explorar el nuevo horizonte de la posibilidad de provocar reacciones en cadena. Para ello era necesario que, en la fisión del uranio, se produjera más de un neutrón. Joliot en París calculó un valor medio de 3,5 neutrones, mientras en Columbia Fermi contabilizaba dos neutrones. La reacción en cadena era, pues, una realidad. Algo que había predicho en 1934 Leo Szilard a raíz del descubrimiento de la radiactividad artificial por Irène Curie y Frédéric Joliot.Szilard, consciente del peligro que entrañaba la bomba atómica en manos de la Alemania nazi, se dirigió a Albert Einstein para que alertara al presidente de los Estados Unidos, Franklin Delano Roosevelt. Es la famosa carta de Einstein del 2 de agosto de 1939: "Trabajos recientes de E. Fermi y L. Szilard..., me hacen esperar que el elemento uranio pueda convertirse en una nueva e importante fuente de energía en el futuro inmediato... En el curso de los cuatro últimos meses se ha hecho probable -...- que pueda ser posible establecer una reacción nuclear en cadena en una gran masa de uranio... Este nuevo fenómeno conduciría también a la construcción de bombas y es concebible (...) que de esta manera se puedan construir bombas de un nuevo tipo extremadamente poderosas... En vista de esta situación, acaso pueda usted considerar aconsejable que exista algún contacto permanente entre la administración y el grupo de físicos que trabajan en reacciones en cadena en Estados Unidos".

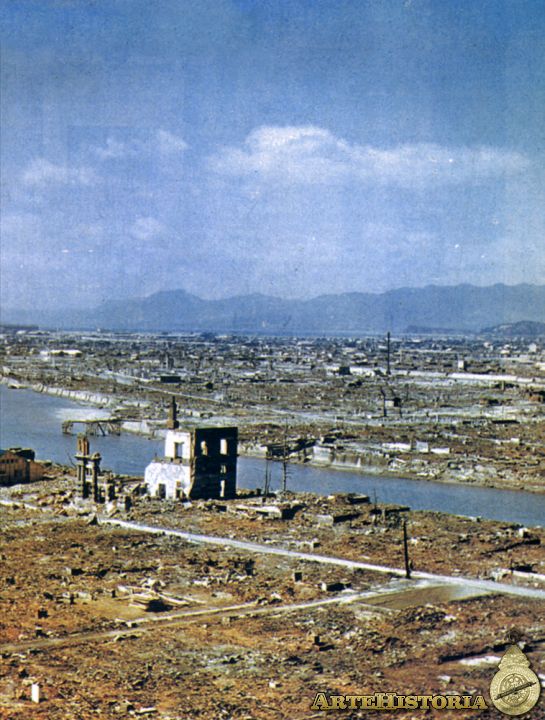

En octubre de 1939 se creaba un comité presidencial encabezado por Lyman J. Briggs, era el primer paso del llamado "proyecto Manhattan" que desembocaría en la fabricación de las primeras bombas atómicas. A principios de 1941, en plena guerra mundial, Ernest Lawrence se involucraba directamente en el proyecto. Desde que tuvo conocimiento de los trabajos de Hahn, Meitner y Frisch había embarcado a su equipo de Berkeley a investigar el proceso de fisión del uranio en los ciclotrones. En la primavera de 1940, Edwin McMillan y Phillip Abelson descubrieron un nuevo elemento producido por la fisión del uranio en el ciclotrón: el neptunio. En febrero de 1941, Glenn T. Seaborg identificaba un nuevo elemento de la desintegración del neptunio: el plutonio; Halban y Kowarski en Cambridge postularon que este nuevo elemento podía ser fisionable con neutrones lentos. De esta forma, se optimizaba la utilización del uranio, puesto que sólo el escasísimo isótopo del uranio U-235 era capaz de generar reacciones en cadena, mientras que el más frecuente U-238 no lo era, a cambio éste podría producir plutonio. Nacía así la posibilidad de la bomba de plutonio, que fue la utilizada en Nagasaki.El siguiente paso lo dieron Otto Frisch y Rudolf Peierls en Gran Bretaña, al calcular aproximadamente la masa crítica de uranio necesaria para desencadenar una reacción en cadena autosostenida. Los cálculos les llevaron a considerar esa masa crítica en torno al medio kilo, cuya reacción en cadena liberaría una energía equivalente a miles de toneladas de TNT.

La bomba atómica era ya una posibilidad real. En noviembre de 1942 se inauguraba en Nuevo México el laboratorio de Los Alamos, bajo la dirección de Robert Oppenheimer, donde se realizaron las pruebas de la primera bomba atómica. Al amanecer del 16 de julio de 1945 estallaba en el desierto de Nuevo México la primera bomba atómica. El 6 de agosto una bomba atómica de uranio, con una potencia de 20.000 toneladas de TNT y unos 4.500 kilos de peso, arrasaba Hiroshima. El 9 de agosto de 1945 una bomba de plutonio arrasaba Nagasaki. Nacía así la "era nuclear".Una de las derivaciones del "proyecto Manhattan" fue el impulso que recibió la electrónica, sentando las bases prácticas para el desarrollo de los computadores. La participación de John von Neumann en el "proyecto Manhattan" fue, a este respecto, decisiva. Las necesidades de cálculo requeridas para el desarrollo del programa nuclear exigían nuevas innovaciones. Von Neumann conoció por Hermann Goldstine el proyecto de la Morre School of Electronics Engineering de la Universidad de Pennsylvania, embarcada en la construcción del computador electrónico ENIAC (Electronic Numerical Integrator And Computer) para los Ballistic Research Laboratories, que contaba con 18.000 válvulas. Von Neumann se incorporó al proyecto en el ámbito de la organización lógica. Al finalizar la guerra, Von Neumann se dedicó al desarrollo de máquinas más potentes, que culminaron con la construcción, en Princeton, de la JOHNNIAC, que entró en funcionamiento en 1952.

Era el comienzo de la "era de los computadores". El desarrollo de la "física del estado sólido" en el campo de los semiconductores contribuyó decisivamente a ello. En 1947, el descubrimiento del transistor en los Laboratorios Bell, por Brattain, Bardeen y Shckey, permitió sustituir las viejas y aparatosas válvulas de vacío por los transistores, que redujeron las dimensiones e incrementaron las velocidades de cálculo de los computadores electrónicos.Sin embargo, los antecedentes de los computadores se remontan más atrás en el tiempo. En 1930, Vannevar Bush desarrolló el analizador diferencial, base sobre la que se fundamentaron los "computadores analógicos". El siguiente paso se debe a Howard Aiken, creador del Automatic Sequence Controlled Calculator, más conocido como Harvard Mark I, iniciado en 1939 y que entró en funcionamiento en 1944, que podía controlar toda la secuencia de cálculos, lectura de datos e instrucciones en un punto a impresionar sus resultados. Von Neumann y Goldstine avanzaron en el diseño lógico de los computadores, resolviendo los problemas asociados al almacenamiento de datos y programas en una memoria en común, proponiendo el sistema numérico binario, que se aplicó por primera vez en 1949 en el EDSAC de la Universidad de Cambridge y es de la base sobre la que se asientan los computadores desde entonces. Las ideas de von Neumann encontraron su plasmación más acabada en Princeton, el primer prototipo fue el IAS, o máquinas de Von Neumann, a partir de la que se construyeron la AVIDAC, la ORDVAC, la ORACLE, la SILLIAC, la ILLIAC, la MANIAC o la JOHNNIAC antes mencionada.

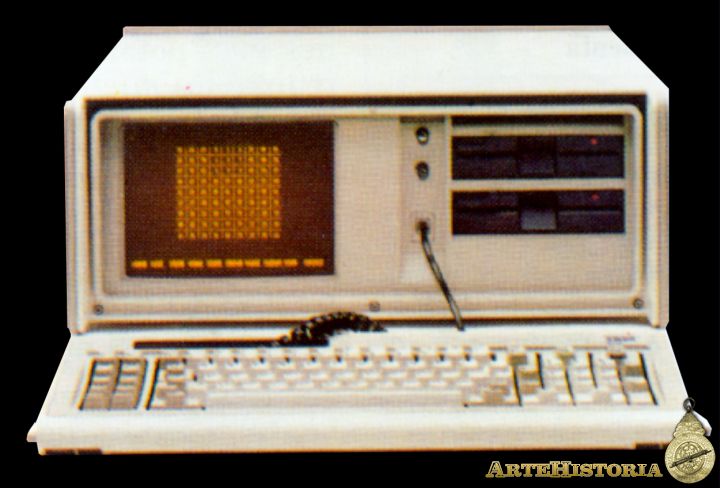

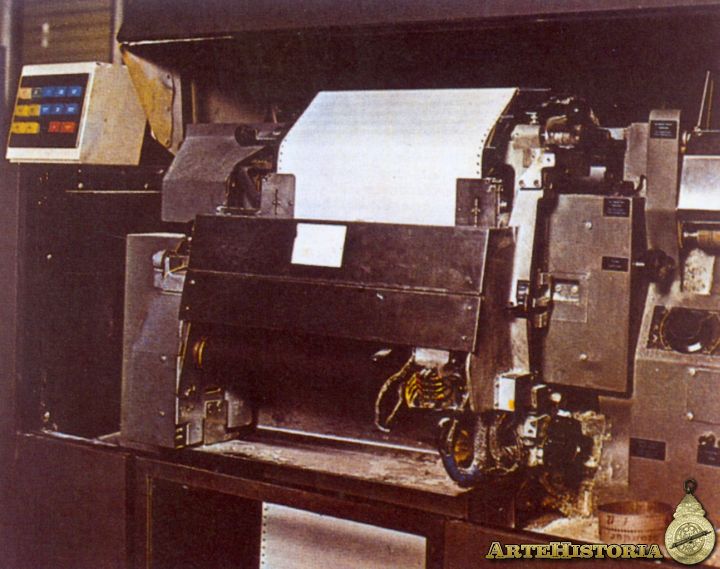

Sobre el modelo estándar de las IAS, la IBM introdujo el sistema de tarjetas perforadas que permitió desarrollar la IBM-701 en 1953. Un año más tarde aparecía la IBM-650 y en 1959 la IBM-1401. En esta época, Jack Kilby de TI y Robert Noyce de Fairchild Semiconductor crearon el primer circuito integrado, conjunto de transistores y resistencias interconectados, nacía así el chip, que permitiría dar un salto de gigante en la construcción de computadoras y, en general, en la microelectrónica. Si a principios de los años sesenta un chip incorporaba unos cuantos transistores microminiaturizados, a finales del decenio de los ochenta un microchip incorpora millones de transistores. En abril de 1964 IBM desarrollaba el System/360, primera familia de computadores compatibles y, en 1981, creaba la primera computadora personal. En abril de 1976 Steve Wozniak y Steve Jobs fundaban la Apple Computer, que fabricaría la gama de computadores personales competidora con el sistema IBM, los Macintosh. En 1987, IBM lanzó al mercado el IBM PS/2, que ha reemplazado su anterior línea de computadoras personales.El avance en el campo de los ordenadores ha exigido combinar diferentes disciplinas desde la lógica formal a la física cuántica, pasando por la física del estado sólido, la cibernética, la teoría de la información, la ciencia de sistemas y la teoría de sistemas. Dos ramas han sido precisas para ello: el "hardware", o soporte material de los computadores, esto es la estructura de las máquinas, donde la física del estado sólido ha sido trascendental, al permitir desarrollar los transistores y, posteriormente, los microchips, mediante los avances registrados en el campo de la semiconductividad y más recientemente de la superconductividad, en los que la física cuántica es fundamental, logrando máquinas infinitamente más potentes y reducidas; y el "software", o lenguajes de programación, donde las matemáticas, la lógica formal, la teoría de la información y la teoría de sistemas han desempeñado un papel esencial, dando lugar a nuevas aplicaciones fruto del avance de la programación computacional, un campo donde el concepto de algoritmo es imprescindible.

Los trabajos del británico Alan M. Turing en 1936, Emil Post en 1943 y Markov en 1947 han sido básicos en el desarrollo de la teoría algorítmica, cuyos antecedentes inmediatos se sitúan en el cálculo lambda de Alonzo Church y las funciones recursivas generales de Gödel. La máquina universal de Turing es un sistema matemático diseñado para manejar el problema general del cálculo no un objeto, de manera que para un argumento dado el valor de la función puede encontrarse utilizando sólo reglas preasignadas, aplicadas por la computadora y construidas previamente en su estructura. Su importancia reside en el hecho de que una máquina universal de Turing puede en principio ejecutar todo tipo de cálculo que sea realizable, Church señaló en 1936 que es el mecanismo más general posible para la solución de un problema resoluble. Shannon ha reducido el número de estados internos de la máquina de Turing a sólo dos, simplificando considerablemente el diseño de una máquina de Turing.Von Neumann ha extendido el principio de la máquina universal de Turing a los procesos biológicos regidos por los mecanismos de replicación del DNA. Lo que ha llevado a los defensores de la "Inteligencia artificial fuerte" a pensar en la posibilidad de construir máquinas inteligentes, abriendo un nuevo campo en el que se entrelazan la física y química cuánticas con la bioquímica del cerebro y la cibernética. En la actualidad los computadores, tanto en serie como en paralelo, se basan en los principios de la máquina universal de Turing. Sin embargo, el propio Turing ha reconocido posteriormente que no puede existir un algoritmo general capaz de decidir sobre todas las cuestiones matemáticas. A ello ha contribuido decisivamente el teorema de incompletud de Gödel, al demostrar que el programa de David Hilbert era irrealizable, en tanto en cuanto cualquiera de los sistemas de matemáticas formales de axiomas y reglas de inferencia debe contener algunos enunciados que no son demostrables ni indemostrables con los medios permitidos dentro del sistema.

Stanley Livingston en Berkeley. Paralelamente, en la Universidad de Columbia (Nueva York), Harold Urey y su equipo descubrían un isótopo del hidrógeno: el deuterio, cuyo poder desintegrador era diez veces más potente que los protones. En 1936, con un ciclotrón más potente, se logró medir el momento magnético del neutrón, produciéndose además el primer elemento artificial: el tecnecio. El ciclotrón posibilitó la creación de isótopos radiactivos que pronto revelaron importantes aplicaciones, entre otras, en el campo de la medicina para el diagnóstico y tratamiento del cáncer.En 1938, Otto Hahn junto con su colaborador Fritz Strassmann observó con sorpresa la producción de bario como consecuencia del bombardeo del uranio con neutrones. Se encontraban frente a la primera reacción de fisión nuclear conocida. El 6 de enero de 1939 publicaban sorprendidos estos resultados. Lisa Meitner, antigua colaboradora de Hahn y exiliada en Estocolmo por su origen judío, fue la primera en interpretar correctamente el alcance del descubrimiento de Hahn junto con su sobrino Otto R. Frisch. La aplicación de la fórmula einsteiniana E = mc2 a la fisión del uranio revelaba dicho proceso como una fuente inagotable de energía. Las bases de la bomba atómica estaban puestas. La proximidad de la Segunda Guerra Mundial aceleró el proceso.Frisch comunicó los cálculos a Niels Bohr en Copenhague antes de que partiera a Estados Unidos. El 16 de enero de 1939, Bohr y su colaborador Leon Rosenfeld se encontraron en Nueva York con John Wheeler y Enrico Fermi, a los que comunicaron el hallazgo de Hahn y los resultados de Meitner y Frisch.

Inmediatamente los físicos en Norteamérica comenzaron a explorar el nuevo horizonte de la posibilidad de provocar reacciones en cadena. Para ello era necesario que, en la fisión del uranio, se produjera más de un neutrón. Joliot en París calculó un valor medio de 3,5 neutrones, mientras en Columbia Fermi contabilizaba dos neutrones. La reacción en cadena era, pues, una realidad. Algo que había predicho en 1934 Leo Szilard a raíz del descubrimiento de la radiactividad artificial por Irène Curie y Frédéric Joliot.Szilard, consciente del peligro que entrañaba la bomba atómica en manos de la Alemania nazi, se dirigió a Albert Einstein para que alertara al presidente de los Estados Unidos, Franklin Delano Roosevelt. Es la famosa carta de Einstein del 2 de agosto de 1939: "Trabajos recientes de E. Fermi y L. Szilard..., me hacen esperar que el elemento uranio pueda convertirse en una nueva e importante fuente de energía en el futuro inmediato... En el curso de los cuatro últimos meses se ha hecho probable -...- que pueda ser posible establecer una reacción nuclear en cadena en una gran masa de uranio... Este nuevo fenómeno conduciría también a la construcción de bombas y es concebible (...) que de esta manera se puedan construir bombas de un nuevo tipo extremadamente poderosas... En vista de esta situación, acaso pueda usted considerar aconsejable que exista algún contacto permanente entre la administración y el grupo de físicos que trabajan en reacciones en cadena en Estados Unidos".

En octubre de 1939 se creaba un comité presidencial encabezado por Lyman J. Briggs, era el primer paso del llamado "proyecto Manhattan" que desembocaría en la fabricación de las primeras bombas atómicas. A principios de 1941, en plena guerra mundial, Ernest Lawrence se involucraba directamente en el proyecto. Desde que tuvo conocimiento de los trabajos de Hahn, Meitner y Frisch había embarcado a su equipo de Berkeley a investigar el proceso de fisión del uranio en los ciclotrones. En la primavera de 1940, Edwin McMillan y Phillip Abelson descubrieron un nuevo elemento producido por la fisión del uranio en el ciclotrón: el neptunio. En febrero de 1941, Glenn T. Seaborg identificaba un nuevo elemento de la desintegración del neptunio: el plutonio; Halban y Kowarski en Cambridge postularon que este nuevo elemento podía ser fisionable con neutrones lentos. De esta forma, se optimizaba la utilización del uranio, puesto que sólo el escasísimo isótopo del uranio U-235 era capaz de generar reacciones en cadena, mientras que el más frecuente U-238 no lo era, a cambio éste podría producir plutonio. Nacía así la posibilidad de la bomba de plutonio, que fue la utilizada en Nagasaki.El siguiente paso lo dieron Otto Frisch y Rudolf Peierls en Gran Bretaña, al calcular aproximadamente la masa crítica de uranio necesaria para desencadenar una reacción en cadena autosostenida. Los cálculos les llevaron a considerar esa masa crítica en torno al medio kilo, cuya reacción en cadena liberaría una energía equivalente a miles de toneladas de TNT.

La bomba atómica era ya una posibilidad real. En noviembre de 1942 se inauguraba en Nuevo México el laboratorio de Los Alamos, bajo la dirección de Robert Oppenheimer, donde se realizaron las pruebas de la primera bomba atómica. Al amanecer del 16 de julio de 1945 estallaba en el desierto de Nuevo México la primera bomba atómica. El 6 de agosto una bomba atómica de uranio, con una potencia de 20.000 toneladas de TNT y unos 4.500 kilos de peso, arrasaba Hiroshima. El 9 de agosto de 1945 una bomba de plutonio arrasaba Nagasaki. Nacía así la "era nuclear".Una de las derivaciones del "proyecto Manhattan" fue el impulso que recibió la electrónica, sentando las bases prácticas para el desarrollo de los computadores. La participación de John von Neumann en el "proyecto Manhattan" fue, a este respecto, decisiva. Las necesidades de cálculo requeridas para el desarrollo del programa nuclear exigían nuevas innovaciones. Von Neumann conoció por Hermann Goldstine el proyecto de la Morre School of Electronics Engineering de la Universidad de Pennsylvania, embarcada en la construcción del computador electrónico ENIAC (Electronic Numerical Integrator And Computer) para los Ballistic Research Laboratories, que contaba con 18.000 válvulas. Von Neumann se incorporó al proyecto en el ámbito de la organización lógica. Al finalizar la guerra, Von Neumann se dedicó al desarrollo de máquinas más potentes, que culminaron con la construcción, en Princeton, de la JOHNNIAC, que entró en funcionamiento en 1952.

Era el comienzo de la "era de los computadores". El desarrollo de la "física del estado sólido" en el campo de los semiconductores contribuyó decisivamente a ello. En 1947, el descubrimiento del transistor en los Laboratorios Bell, por Brattain, Bardeen y Shckey, permitió sustituir las viejas y aparatosas válvulas de vacío por los transistores, que redujeron las dimensiones e incrementaron las velocidades de cálculo de los computadores electrónicos.Sin embargo, los antecedentes de los computadores se remontan más atrás en el tiempo. En 1930, Vannevar Bush desarrolló el analizador diferencial, base sobre la que se fundamentaron los "computadores analógicos". El siguiente paso se debe a Howard Aiken, creador del Automatic Sequence Controlled Calculator, más conocido como Harvard Mark I, iniciado en 1939 y que entró en funcionamiento en 1944, que podía controlar toda la secuencia de cálculos, lectura de datos e instrucciones en un punto a impresionar sus resultados. Von Neumann y Goldstine avanzaron en el diseño lógico de los computadores, resolviendo los problemas asociados al almacenamiento de datos y programas en una memoria en común, proponiendo el sistema numérico binario, que se aplicó por primera vez en 1949 en el EDSAC de la Universidad de Cambridge y es de la base sobre la que se asientan los computadores desde entonces. Las ideas de von Neumann encontraron su plasmación más acabada en Princeton, el primer prototipo fue el IAS, o máquinas de Von Neumann, a partir de la que se construyeron la AVIDAC, la ORDVAC, la ORACLE, la SILLIAC, la ILLIAC, la MANIAC o la JOHNNIAC antes mencionada.

Sobre el modelo estándar de las IAS, la IBM introdujo el sistema de tarjetas perforadas que permitió desarrollar la IBM-701 en 1953. Un año más tarde aparecía la IBM-650 y en 1959 la IBM-1401. En esta época, Jack Kilby de TI y Robert Noyce de Fairchild Semiconductor crearon el primer circuito integrado, conjunto de transistores y resistencias interconectados, nacía así el chip, que permitiría dar un salto de gigante en la construcción de computadoras y, en general, en la microelectrónica. Si a principios de los años sesenta un chip incorporaba unos cuantos transistores microminiaturizados, a finales del decenio de los ochenta un microchip incorpora millones de transistores. En abril de 1964 IBM desarrollaba el System/360, primera familia de computadores compatibles y, en 1981, creaba la primera computadora personal. En abril de 1976 Steve Wozniak y Steve Jobs fundaban la Apple Computer, que fabricaría la gama de computadores personales competidora con el sistema IBM, los Macintosh. En 1987, IBM lanzó al mercado el IBM PS/2, que ha reemplazado su anterior línea de computadoras personales.El avance en el campo de los ordenadores ha exigido combinar diferentes disciplinas desde la lógica formal a la física cuántica, pasando por la física del estado sólido, la cibernética, la teoría de la información, la ciencia de sistemas y la teoría de sistemas. Dos ramas han sido precisas para ello: el "hardware", o soporte material de los computadores, esto es la estructura de las máquinas, donde la física del estado sólido ha sido trascendental, al permitir desarrollar los transistores y, posteriormente, los microchips, mediante los avances registrados en el campo de la semiconductividad y más recientemente de la superconductividad, en los que la física cuántica es fundamental, logrando máquinas infinitamente más potentes y reducidas; y el "software", o lenguajes de programación, donde las matemáticas, la lógica formal, la teoría de la información y la teoría de sistemas han desempeñado un papel esencial, dando lugar a nuevas aplicaciones fruto del avance de la programación computacional, un campo donde el concepto de algoritmo es imprescindible.

Los trabajos del británico Alan M. Turing en 1936, Emil Post en 1943 y Markov en 1947 han sido básicos en el desarrollo de la teoría algorítmica, cuyos antecedentes inmediatos se sitúan en el cálculo lambda de Alonzo Church y las funciones recursivas generales de Gödel. La máquina universal de Turing es un sistema matemático diseñado para manejar el problema general del cálculo no un objeto, de manera que para un argumento dado el valor de la función puede encontrarse utilizando sólo reglas preasignadas, aplicadas por la computadora y construidas previamente en su estructura. Su importancia reside en el hecho de que una máquina universal de Turing puede en principio ejecutar todo tipo de cálculo que sea realizable, Church señaló en 1936 que es el mecanismo más general posible para la solución de un problema resoluble. Shannon ha reducido el número de estados internos de la máquina de Turing a sólo dos, simplificando considerablemente el diseño de una máquina de Turing.Von Neumann ha extendido el principio de la máquina universal de Turing a los procesos biológicos regidos por los mecanismos de replicación del DNA. Lo que ha llevado a los defensores de la "Inteligencia artificial fuerte" a pensar en la posibilidad de construir máquinas inteligentes, abriendo un nuevo campo en el que se entrelazan la física y química cuánticas con la bioquímica del cerebro y la cibernética. En la actualidad los computadores, tanto en serie como en paralelo, se basan en los principios de la máquina universal de Turing. Sin embargo, el propio Turing ha reconocido posteriormente que no puede existir un algoritmo general capaz de decidir sobre todas las cuestiones matemáticas. A ello ha contribuido decisivamente el teorema de incompletud de Gödel, al demostrar que el programa de David Hilbert era irrealizable, en tanto en cuanto cualquiera de los sistemas de matemáticas formales de axiomas y reglas de inferencia debe contener algunos enunciados que no son demostrables ni indemostrables con los medios permitidos dentro del sistema.